Cette semaine, après avoir vu les bases de l’intelligence artificielle, le MVP Challenge m’a amené sur un terrain un peu plus avancé du Data & AI par rapport à différents services cognitifs qu’on peut utiliser via Azure. Voici un résumé de ce que j’ai appris!

La première partie est disponible ici: Partie 1

La deuxième partie est disponible ici: Partie 2

La troisième partie est disponible ici: Partie 3

La quatrième partie: vous êtes ici

La cinquième partie est disponible ici: Partie 5

Azure Content Moderator

Le tout a commencé par un service que je n’avais pas encore vu, qui permet la modération d’images, de textes et de vidéos, assisté par l’AI évidemment. Ce service permet de détecter des items profanes ou explicites par exemple et peut même nous retourner une classification sur les éléments explicites, nous indiquant si on devrait faire une revue du contenu. Dans un monde où la main-d’oeuvre est souvent débordée, ce genre de service peut venir alléger la tâche des gens pour uniquement faire de la modération sur ce qui est jugé offensant. Comme tout est utilisable via un API, c’est plutôt simple à mettre en place, un exemple très complet pour l’essayer est d’ailleurs disponible ici.

Analyse de sentiments

Une autre belle découverte, l’analyse de sentiments grâce à l’API Text Analytics. J’avais vu brièvement dans une leçon précédante le fonctionnement de ceci, mais cette fois-ci je l’ai vu dans un exemple beaucoup plus concrèt. J’ai vu comment mettre un système de queues en places avec le Azure Queue Storage et avec une Azure Function pour recevoir des messages, déterminer s’ils sont positifs, négatifs ou neutres, puis transférer selon le résultat dans la bonne file du Queue Storage.

Speech Service

Encore une fois quelque chose que j’avais vu plus tôt dans le mois, mais plus concrètement en utilisant différents APIs pour consommer les services. Dans la conversion de l’audio à du texte, comme dans la traduction, l’utilisation de l’API est sensiblement la même. On construit l’objet qu’on a besoin (un SpeechRecognizer pour faire du speech-to-text par exemple) à partir d’un SpeechConfig pour se connecter au service sur Azure, d’un AudioConfig pour choisir un fichier audio au lieu du micro par exemple, puis il ne reste qu’à consommer le résultat de la méthode utilisée, qui s’occupe d’appeler le service cognitif qui fait le travail.

Analyse d’images et vidéos

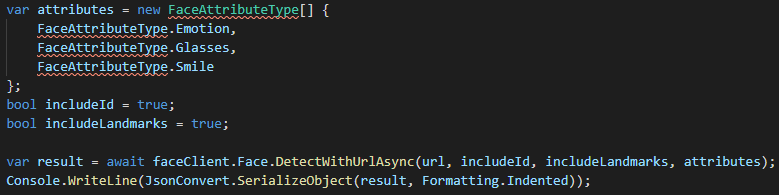

Je suis aussi retourné dans l’analyse d’images sur différents aspects, entre autre avec le Face API. De voir que l’utilisation peut se faire grâce à des SDK rend l’utilisation beaucoup plus facilement approchable. Par exemple, ces quelques lignes de code permettent de détecter les émotions, les lunettes, les sourires ainsi que les différents points d’identifications (landmarks) sur une image:

L’analyse de vidéo est quelque chose que je n’avais pas encore vu et qui regroupe beaucoup des concepts des services cognitifs. En résumé, le service Azure Video Indexer permet de prendre des vidéos et d’en extraire des scènes, des identifications de visages, de la reconnaissance de texte, et même de la transcription et de l’analyse d’émotions dans l’audio. Au final, on se retrouve avec une tonne d’information qui nous permettrait par exemple de faire de la recherche sur des vidéos selon le contenu de ceux-ci.

Language Understanding

De ce côté, j’ai eu la chance de voir quelques concepts de plus que ce que j’avais écrit la semaine dernière. Par exemple, il existe des domaines pré-construits qu’on peut ajouter à nos projets LUIS avec quelques cliques, qui vont s’occuper d’ajouter uen grande sélection d’intentions et d’entités à notre modèle sans que nous ayons à le faire nous-même.

J’ai aussi vu qu’il était facile d’exporter une application LUIS vers un docker, avec une option disponible directement dans le menu d’export. Une chose importante à savoir avec ceci par contre est qu’il y a certaines limitations à déployer une application LUIS dans un conteneur, qui sont toutes répertoriées dans la documentation.

Conclusion

Cette semaine fût beaucoup plus chargée en terme d’utilisation des différents APIs, mais extrêmement intéressante parce qu’au-delà de comprendre les concepts vus dans les dernières semaines, j’ai pu voir la simplicité d’utilisation avec les différents SDK disponibles. Je n’ai pas de nouvelle collection d’apprentissage cette semaine, j’ai plutôt mis à jour ceux que j’avais déjà, donc le mieux pour voir les éléments ajoutés serait de les consulter:

Collection sur le Data & AI: Voir la collection

Collection sur le Machine Learning: Voir la collection

Collection sur l’analyse d’images: Voir la collection

Collection sur l’analyse de mots: Voir la collection

Bruno

MVP CHALLENGE

La première partie est disponible ici: Partie 1

La deuxième partie est disponible ici: Partie 2

La troisième partie est disponible ici: Partie 3

La quatrième partie: vous êtes ici

La cinquième partie est disponible ici: Partie 5